现在Spark支撑四种办法从数据库中读取数据,这里以Mysql为例进行介绍。

一、不指定查询条件

这个办法连接MySql的函数原型是:

咱们只需求供给Driver的url,需求查询的表名,以及连接表有关特点properties。下面是详细比如:

咱们运转上面的程序,能够看到df.rdd.partitions.size输出成果是1,这个成果的意义是iteblog表的所有数据都是由RDD的一个分区处理的,所以说,假如你这个表很大,很可能会呈现OOM

这种办法在数据量大的时分不主张运用。

二、指定数据库字段的规模

这种办法即是经过指定数据库中某个字段的规模,可是惋惜的是,这个字段有必要是数字,来看看这个函数的函数原型:

前两个字段的意义和办法一相似。columnName即是需求分区的字段,这个字段在数据库中的类型有必要是数字;lowerBound即是分区的下界;upperBound即是分区的上界;numPartitions是分区的个数。同样,咱们也来看看怎么运用:

这个办法能够将iteblog表的数据散布到RDD的几个分区中,分区的数量由numPartitions参数决议,在抱负情况下,每个分区处理一样数量的数据,咱们在运用的时分不主张将这个值设置的比较大,由于这可能致使数据库挂掉!可是根据前面介绍,这个函数的缺陷即是只能运用整形数据字段作为分区关键词。

这个函数在极端情况下,也即是设置将numPartitions设置为1,其意义和第一种办法共同。

三、根据恣意字段进行分区

根据前面两种办法的约束,Spark还供给了根据恣意字段进行分区的办法,函数原型如下:

这个函数相比第一种办法多了predicates参数,咱们能够经过这个参数设置分区的根据,来看看比如:

最终rdd的分区数量就等于predicates.length。 四、经过load获取

Spark还供给经过load的办法来读取数据。

options函数支撑url、driver、dbtable、partitionColumn、lowerBound、upperBound以及numPartitions选项,仔细的同学必定发现这个和办法二的参数共同。是的,其内部完成原理部分和办法二大体共同。一起load办法还支撑json、orc等数据源的读取 (责任编辑:最模板) |

Spark读取数据库(Mysql)的四种方式讲解

时间:2016-01-07 16:14来源:未知 作者:最模板 点击:次

现在Spark支撑四种办法从数据库中读取数据,这里以Mysql为例进行介绍。 一、不指定查询条件 这个办法连接MySql的函数原型是: def jdbc(url: String, table: String, properties: Properties): DataFrame 咱

顶一下

(0)

0%

踩一下

(0)

0%

------分隔线----------------------------

- 热点内容

-

- 在MySQL数据库中创建一个完整的表

1.登陆MySQL成功后,首先进入某一个数据库 (不是指数据库服务...

- 在Centos6.6上安装MySQL5.7.12时没有my

在Centos6.6上安装MySQL5.7.12,后在/root目录下没有发现有.mysql_secret这...

- 最详细的远程访问Mysql解决方案

网上关于mysql开启远程访问的文章五花八门,不是特别详细,这...

- MySQL之日志和mysqlbinlog工具的使用

查看日志相关的全局变量:mysqlSHOW GLOBAL VARIABLES LIKE %log% 修改相...

- Spark读取数据库(Mysql)的四种方式

目前Spark支持四种方式从数据库中读取数据,这里以Mysql为例进行...

- 在MySQL数据库中创建一个完整的表

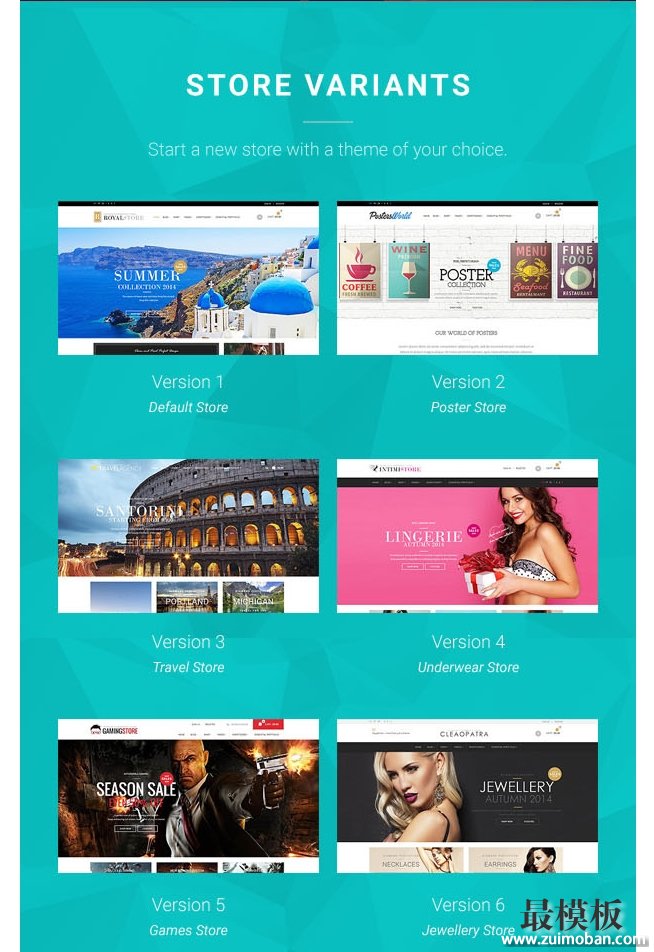

- 随机模板

-

-

外贸珠宝饰品ecshop模板

人气:609

外贸珠宝饰品ecshop模板

人气:609

-

英文ecshop假发类外贸商城

人气:1570

英文ecshop假发类外贸商城

人气:1570

-

ROYAL外贸综合商品Magento商

人气:173

ROYAL外贸综合商品Magento商

人气:173

-

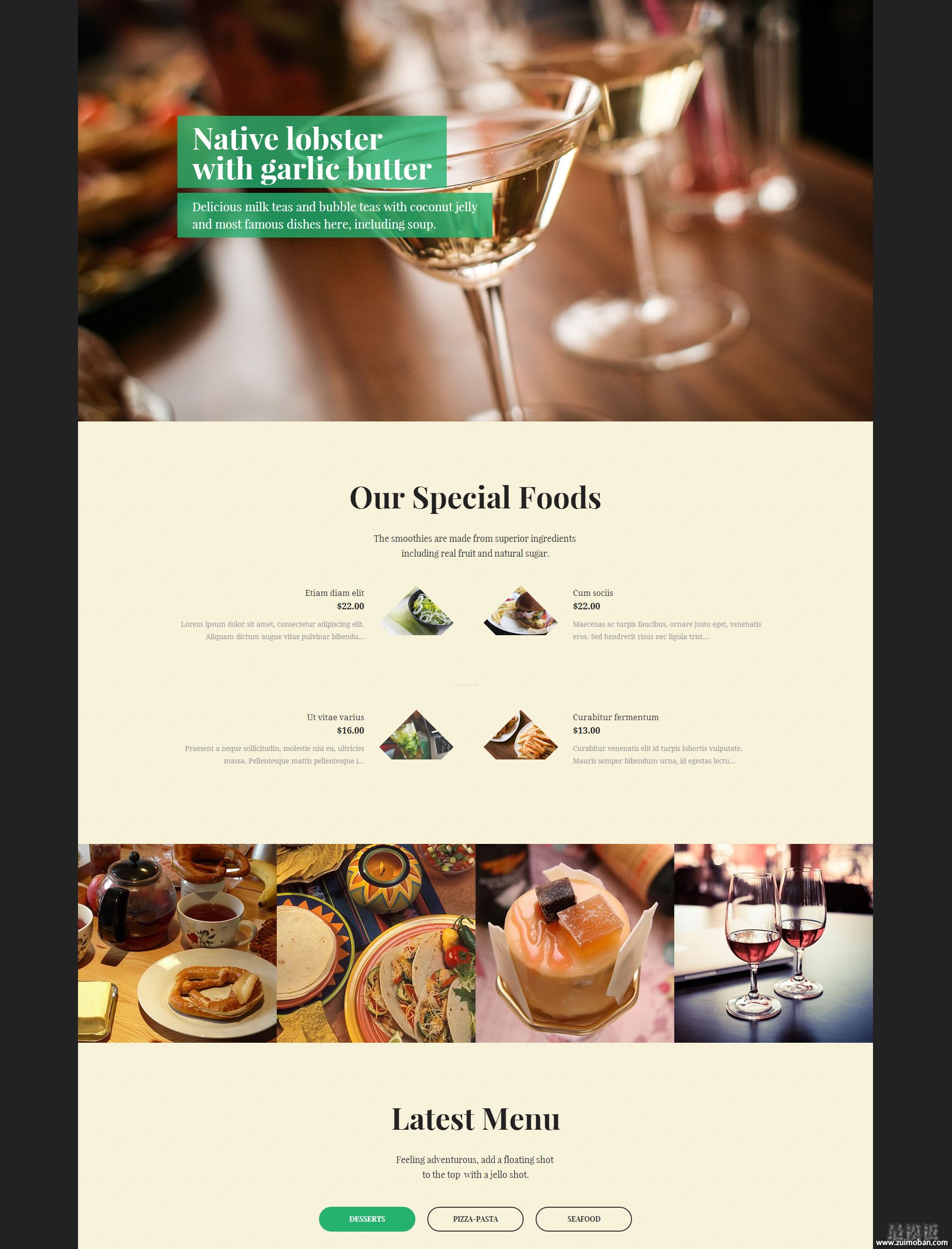

Magento时尚餐厅主题模板

人气:268

Magento时尚餐厅主题模板

人气:268

-

ecshop 抽奖插件

人气:2222

ecshop 抽奖插件

人气:2222

-

2011版兰亭(lightinthebox.com

人气:11278

2011版兰亭(lightinthebox.com

人气:11278

-